Если у Вас возникла необходимость заблокировать доступ к сайту определенным поисковым ботам (роботам) или просто ограничить другие нежелательные запросы к сайту, то данный материал будет Вам полезен, так как в нем мы рассмотрим способ блокировки по User-Agent с использованием файла htaccess.

Например, у меня данная необходимость возникла тогда, когда один из дополнительных поисковых роботов поисковой системы Mail стал посещать несколько тысяч раз в день один из моих сайтов, тем самым создавая нагрузку на сервер.

Первое, что, конечно же, было мной предпринято — это указание директивы Crawl-delay в файле robots.txt. Crawl-delay – это директива, с помощью которой можно задать задержку (в секундах) между двумя запросами поискового робота к сайту.

Директива Crawl-delay была задана конкретно для поисковой системы Mail, однако, как я уже сказал, это был не основной поисковый бот системы, а дополнительный, скорей всего, поэтому указание данной директивы никак не повлияло на работу поискового робота.

В связи с этим для снижения нагрузки на сервер было принято решение заблокировать данного поискового робота. В качестве метода блокировки я использовал очень эффективный инструмент – это блокировка по User-Agent в файле htaccess.

Сейчас я Вам покажу, как можно заблокировать, на самом деле, любые нежелательные запросы к сайту по User-Agent с помощью файла htaccess, на примере блокировки поискового бота.

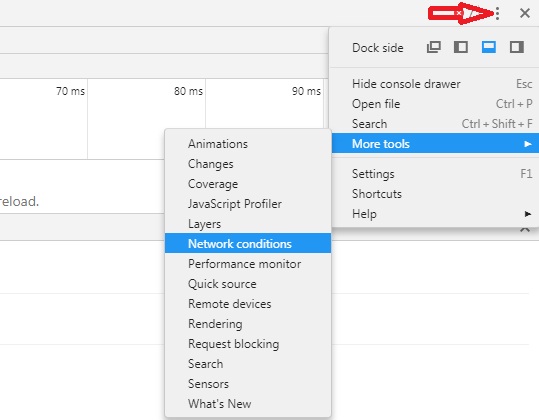

Открываем «Меню -> Дополнительные Инструменты -> Инструменты разработчика» или просто нажимаем клавишу F12.

Затем нажимаем «Три точки ->More tools -> Network conditions».

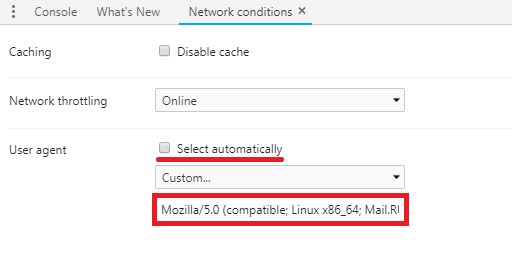

Далее снимаем галочку «Select automatically» и в специальном поле вводим значение необходимого User-Agent. Также из выпадающего списка «Custom» мы можем выбрать предопределенные значения User-Agent, посмотрите, может быть, нужный Вам есть в этом перечне.

После этого в текущей вкладке (эти настройки действуют только для текущей вкладки!) открываем свой сайт, и если мы получаем ошибку «403 В доступе отказано», значит все отлично, блокировка работает.

Заметка! Преимущества разных видов хостинга: выбираем оптимальный вариант для своего сайта.

Изменяем User-Agent в браузере Mozilla Firefox

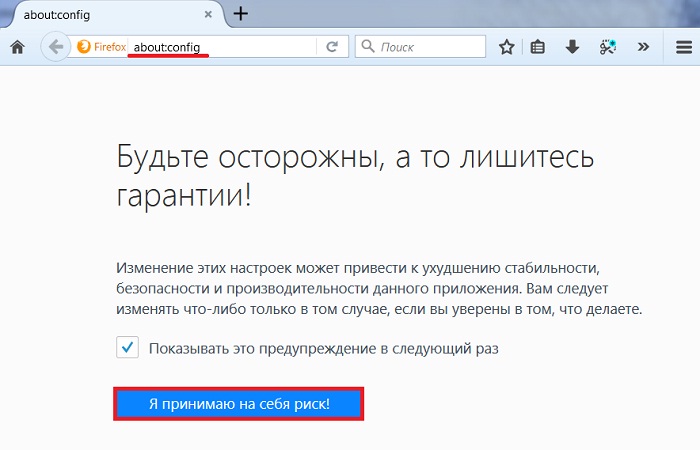

Для изменения User-Agent в браузере Mozilla Firefox необходимо открыть конфигурационные параметры браузера.

Для этого в адресной строке вводим «about:config», при появлении предупреждающего сообщения нажимаем «Я принимаю на себя риск!».

Опрос. Какой браузер самый лучший?

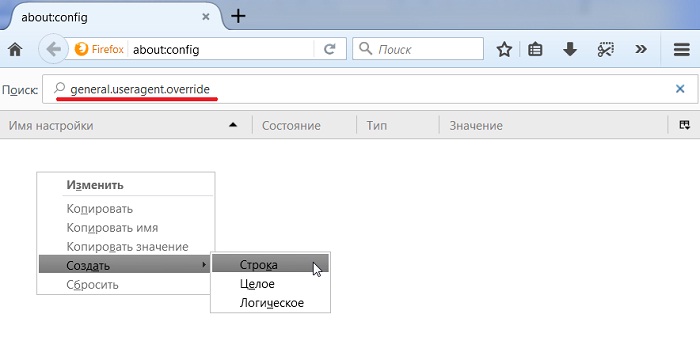

Затем в строку поиска введите название параметра, который отвечает за юзер-агент браузера — это «general.useragent.override», если данный параметр отсутствует, создайте его. Для этого нажмите правой кнопкой мыши в любом месте, и в контекстном меню выберете «Создать -> Строка».

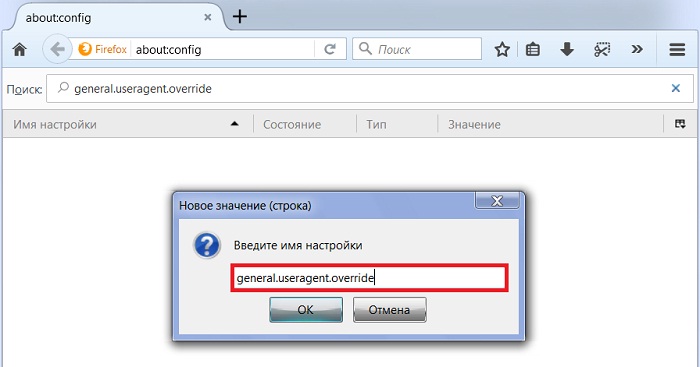

В появившемся окне сначала введите названия параметра «general.useragent.override» и нажмите «ОК».

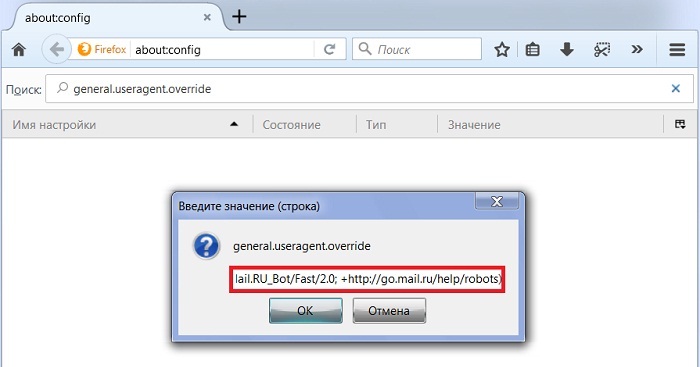

Потом введите значение параметра, т.е. как раз нужный нам User-Agent, у меня это «Mozilla/5.0 (compatible; Linux x86_64; Mail.RU_Bot/Fast/2.0; +http://go.mail.ru/help/robots)», нажимаем «ОК».

Если параметр уже есть, то щелкните по нему правой кнопкой мыши и выберите «Изменить», и в соответствующем поле введите новое значение параметра.

Открывайте новую вкладку и переходите на свой сайт, если ошибка 403, то все ок, и можно сбросить данную настройку.

Кстати, в данном случае новый User-Agent будет действовать уже во всех вкладках до того момента, пока Вы не измените или не удалите параметр «general.useragent.override».

Заметка! ТОП 5 популярных CMS для блога.

Теперь Вы знаете, как можно заблокировать поискового робота по User-Agent в htaccess, а также как изменить юзер-агент в браузерах, у меня все, пока!